AIライティングで「ハルシネーション(嘘)」を防ぐための運用ルール

AIの嘘「ハルシネーション」が引き起こす、見過ごせない経営リスク

AIライティングツールが驚異的なスピードで文章を生成する裏側で、多くの企業が見過ごしている重大なリスクがあります。それが、AIが事実に基づかない情報を生成する現象「ハルシネーション(Hallucination)」です。

例えば、AIに自社の製品仕様について尋ねたところ、存在しない機能を「搭載している」と回答してしまったらどうでしょう。あるいは、顧客からの問い合わせに対し、古い法規制に基づいた誤ったアドバイスを自動生成してしまったらどうなるでしょうか。

これらは単なる「タイプミス」や「間違い」では済みません。顧客の信頼を失い、ブランドイメージを大きく毀損するだけでなく、最悪の場合、法的な責任問題に発展しかねない深刻な「経営リスク」そのものです。AIによる業務効率化という魅力的な果実を得るためには、このハルシネーションという毒を正しく理解し、組織全体で管理下に置くことが不可欠なのです。「うちの会社は大丈夫」は、もはや通用しません。

なぜAIはもっともらしい嘘をつくのか?ハルシネーションの正体

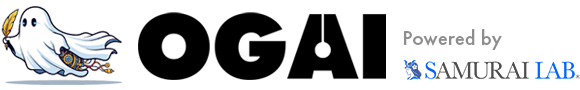

ハルシネーション対策を講じる上で、まず「なぜAIがもっともらしい嘘をつくのか」という根本原因を理解しておく必要があります。一言でいえば、AIは「真実」を理解しているわけではなく、膨大なテキストデータから学習した「単語と単語の繋がり(確率)」に基づいて、次にくる単語を予測しているに過ぎないからです。

AIにとっての最優先事項は、事実として正しいかどうかよりも、「文章として自然で流暢か」どうか。そのため、知識が不足している領域や、文脈が曖昧な質問に対して、学習データの中から最もそれらしい単語を繋ぎ合わせ、「作り話」でその場を乗り切ろうとすることがあるのです。これがハルシネーションの正体です。

原因1:学習データの限界とバイアス

AIの知識は、その学習元となったデータに完全に依存します。インターネット上には、誤った情報、偏った意見、そして古くなった情報が溢れています。AIはこれらの「不完全な情報」を区別なく学習してしまうため、出力にも当然その限界が反映されます。

特に、多くのAIモデルには学習データが特定の時点までのものである「データカットオフ」という問題が存在します。そのため、最新の法改正や市場動向を反映できず、結果として誤った情報を生成するリスクを常に抱えています。AIの回答は、あくまでWeb上の情報の写し鏡であり、その情報の鮮度や正確性は無条件に信頼すべきではないのです。

原因2:文脈理解の失敗と「作り話」の生成

AIは人間のように真の意味で文脈を理解しているわけではありません。特に、複数のトピックが絡み合う複雑な指示や、長文の対話が続くと、文脈の重要な部分を見失ってしまうことがあります。

そして、知識が欠けている部分や、理解できなかった箇所を埋めるために、AIは最も確率的に「ありえそう」な単語を繋ぎ合わせて、もっともらしい「作り話」を生成してしまうのです。これは、AIが決して万能ではなく、その回答の妥当性を判断する人間による監督が、絶対的に不可欠であることを示しています。

AIライティングのハルシネーション対策:2つのアプローチ

では、この厄介なハルシネーションのリスクを、企業はどのように管理すればよいのでしょうか。対策は、大きく2つのアプローチに分けられます。

- 技術的対策:AIへの指示(プロンプト)やシステムを工夫し、ハルシネーションの「発生確率」そのものを下げるアプローチ。

- 組織的対策:発生してしまった誤情報を人間が確実に見抜き、公開を防ぐための「運用ルール」を構築するアプローチ。

重要なのは、どちらか一方だけでは不十分だということです。AIの出力をコントロールする「技術」と、それを監督・検証する「人間の体制」。この両輪が連携して初めて、強固で実用的なリスク管理体制を築くことができるのです。

アプローチ1:発生確率を下げる「技術的対策」

まずは、AIからの出力段階でハルシネーションの発生率を低減させるための、具体的な技術や手法について解説します。これらの対策はリスクをゼロにするものではありませんが、後段の人間によるチェックの負担を大幅に軽減するために極めて重要です。

プロンプトの工夫:具体的で明確な指示を出す

誰でもすぐに実践できる最も基本的な対策が、プロンプト(AIへの指示)の質を高めることです。「曖昧な指示は嘘のもと」と心得ましょう。

- 5W1Hを明確にする:「誰が」「いつ」「どこで」「何を」「なぜ」「どのように」を具体的に指示することで、AIが文脈を誤解するリスクを減らします。

- 役割(Role)を与える:「あなたは〇〇業界の専門家です」といった役割を与えることで、回答の視点や専門性をコントロールします。

- 制約条件を加える:「わからない場合は『不明』と回答してください」「推測で答えないでください」といった制約を設けることは、作り話を抑制する上で非常に有効です。

複雑なプロンプトは必ずしも高品質な結果に繋がるとは限りません。むしろ、シンプルかつ明確な指示こそが、ハルシネーションを防ぐ鍵となります。

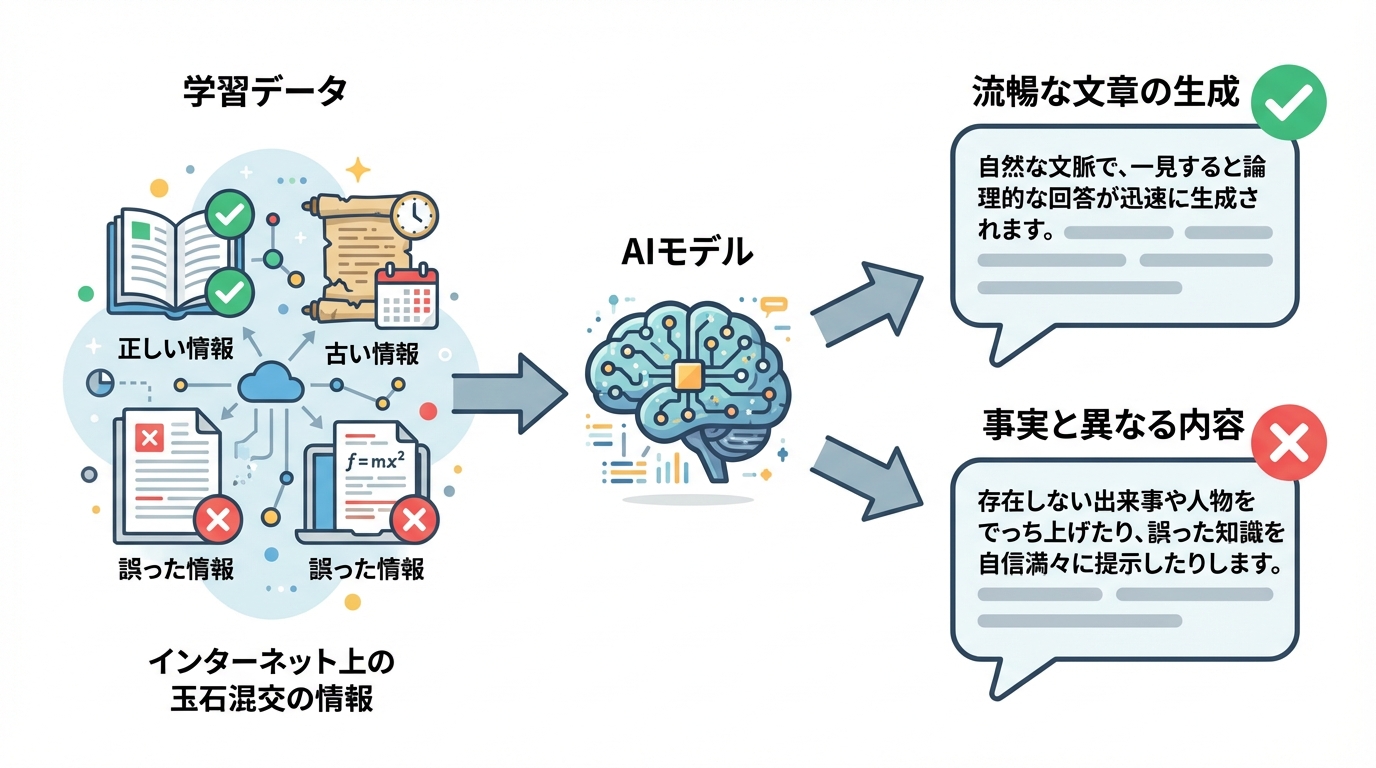

情報源の指定:信頼できる外部データを参照させる(RAG)

より高度な技術的対策として、「RAG(Retrieval-Augmented Generation:検索拡張生成)」や「グラウンディング」と呼ばれる手法があります。

これは、AIが学習済みの膨大な学習データだけで回答を作るのではなく、私たちが指定した特定の情報源(例:社内の製品マニュアル、信頼できる省庁のWebサイト、最新の業界レポートなど)を検索・参照させ、その内容に基づいて回答を生成させる技術です。

このアプローチにより、AIが不確かな情報源から「作り話」を拾ってくることを防ぎ、事実に基づいた信頼性の高い回答を生成させることが可能になります。これは、特に専門性の高いコンテンツや、正確性が絶対的に求められる顧客対応などで非常に有効な手段です。

アプローチ2:誤情報を見抜く「組織的対策(運用ルール)」の構築

ここからが本記事の核心です。どれだけ技術的対策を講じても、ハルシネーションの発生を完全にゼロにすることはできません。最後の砦となるのは、人間の目によるチェック体制です。ここでは、コンプライアンス担当者が知りたい「何を、誰が、どうチェックするのか」という問いに、具体的なステップでお答えします。

ステップ1:AI利用ガイドラインを策定する

まず組織の土台として、全社共通のAI利用ガイドラインを策定することが不可欠です。これにより、従業員のAI利用における認識を統一し、意図しないリスクの発生を防ぎます。最低限、以下の項目は盛り込むべきでしょう。

- 入力禁止情報の定義:個人情報、顧客情報、社外秘の機密情報など、AIに入力してはならない情報を具体的に定義します。

- 生成コンテンツの責任所在:AIが生成したコンテンツの最終的な責任は、AIではなく利用者(人間)にあることを明確に規定します。

- ファクトチェックの義務付け:AIが生成した情報は、公開・利用前に必ず人間による事実確認を行うことを義務付けます。

- 引用・参照元の確認:AIが提示した情報の出典や参照元を確認し、その信頼性を評価するプロセスを定めます。

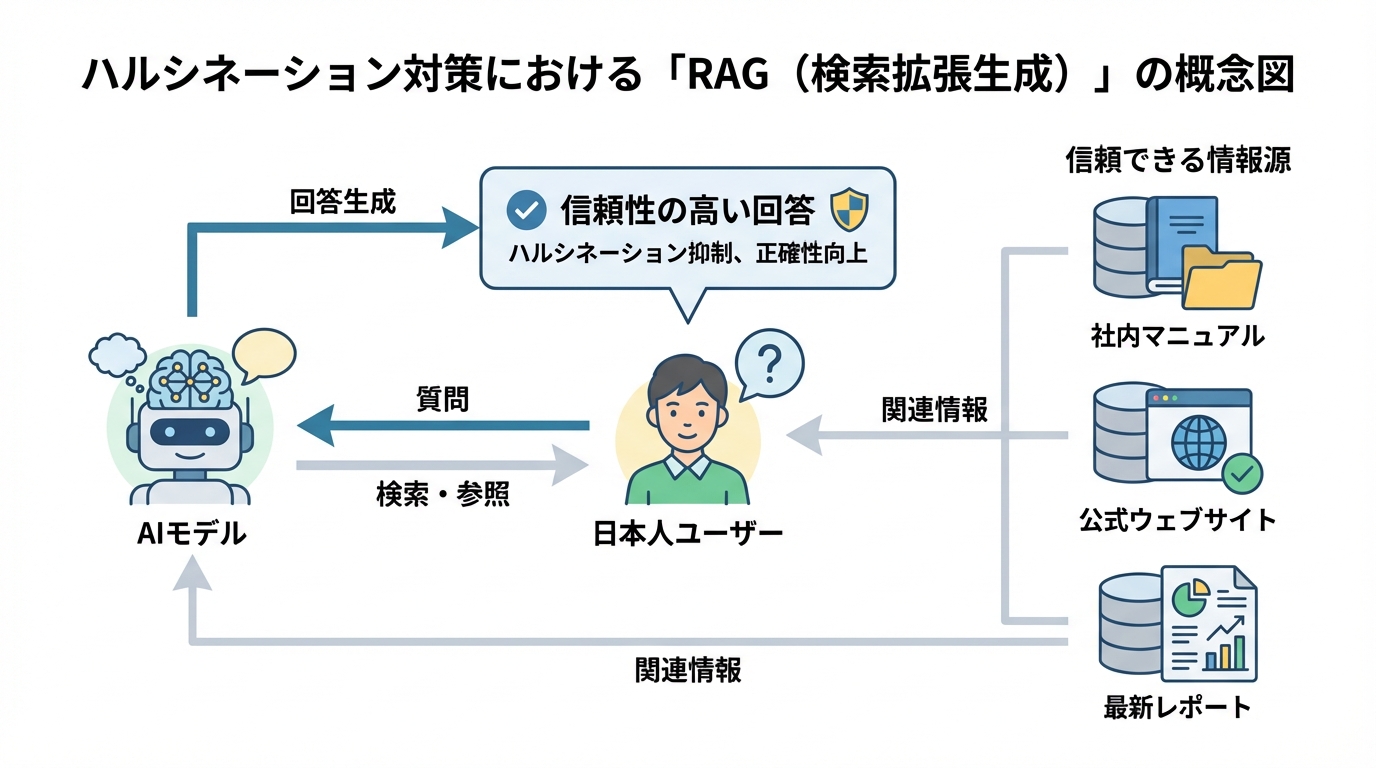

ステップ2:ファクトチェックの運用フローを定める

ガイドラインで義務付けたファクトチェックを、具体的にどのように実行するのか、明確な運用フローを定義します。

「誰が」「いつ」「何を」「どのように」を具体的に定め、担当者による属人化を防ぎ、チェックの質を担保することが重要です。特に、以下の項目は優先的に、かつ厳密にチェックする必要があります。

- 固有名詞:人名、企業名、製品名、地名など

- 数値データ:統計、価格、日付、数量など

- 法的・専門的な記述:法律、規制、医療、金融など、誤りが許されない専門情報

- 引用・出典元:情報源の信頼性、最新性の確認

理想は、コンテンツ作成者自身による一次チェックに加え、別の担当者による二次チェック(ダブルチェック)を行う体制です。これにより、見落としのリスクを大幅に低減できます。

ステップ3:責任の所在を明確にする「編集者・監修者」制度

生成されたコンテンツの最終的な文責は、AIではなく人間にあります。この原則を組織内に浸透させ、チェック体制の形骸化を防ぐために極めて有効なのが、「編集者」や「監修者」の制度です。

公開されるすべてのAI生成コンテンツに、その内容の正確性を承認した担当者(編集者)や、専門分野の知見から内容を担保する専門家(監修者)の名前を明記するルールを導入します。これにより、担当者一人ひとりに「自分が最終責任者である」という当事者意識が生まれ、ファクトチェックの精度が格段に向上します。

さらに、この取り組みはGoogleがコンテンツの品質を評価する上で重視する「経験・専門性・権威性・信頼性(E-E-A-T)」を高めることにも直結します。読者に対して誰がその情報に責任を持っているかを明確に示すことは、内容の信頼性を高めるうえで有効です。また、Googleが示す「E-E-A-T」の考え方(誰が作成したか等を明確にすること)にも沿うため、結果としてSEO上もプラスに働く可能性があります。

まとめ:AI時代、人間の役割は「執筆者」から「事実確認者」へ

本記事では、AIライティングにおけるハルシネーションのリスクと、その対策について「技術的アプローチ」と「組織的アプローチ」の両面から解説しました。ハルシネーションのリスクはゼロにはできませんが、この2つの対策を適切に組み合わせることで、企業はAIを安全かつ効果的に活用することが可能です。

そして、私たちが最も伝えたいメッセージは、AIの登場によって、コンテンツ制作における人間の役割が根本から変わるということです。

これからの時代、人間の最も重要な役割は、ゼロから文章を書き起こす「執筆者(Writer)」ではありません。AIが生み出した膨大な文章の素案の中から、真実を見抜き、誤りを正し、最終的な品質と正確性に責任を負う「編集者(Editor)」であり「事実確認者(Fact-Checker)」へと進化していくのです。

この変化は、私たち株式会社アップラボがAIライティングツール「OGAI」を開発する上での根幹思想でもあります。AIを単なる効率化ツールとして使うのではなく、専門家の強力なアシスタントとして位置づけ、人間はより高度な判断と最終責任に集中する。これこそが、AI時代の新しいコンテンツ制作の姿であると、私たちは確信しています。

参考情報

本記事で解説したAI利用ガイドラインの策定にあたり、以下の公的機関が公開している資料も非常に参考になります。

・テキスト生成AIの導入・運用ガイドライン | 独立行政法人情報処理推進機構(IPA)